近年來,隨著人工智能(AI)模型能力的顯著提升,計算資源的增長為其性能帶來了巨大提升。由於規模化的持續增長,許多人工智能實驗室以每年約4倍的速度擴大訓練計算規模,這一增速甚至超越了歷史上一些最快的技術擴展,例如1980至1987年手機普及的每年2倍增長、2001至2010年太陽能裝機量的每年1.5倍增長,以及2008至2015年人類基因組測序的每年3.3倍增長。

四大限制因素

在最近的一份報告中,Epoch AI 研究了這種每年約4倍的訓練計算增長速度是否能夠持續到2030年,並指出了四個關鍵的制約因素:電力供應、芯片製造能力、數據稀缺以及「延遲牆」,即訓練過程中的計算延遲。

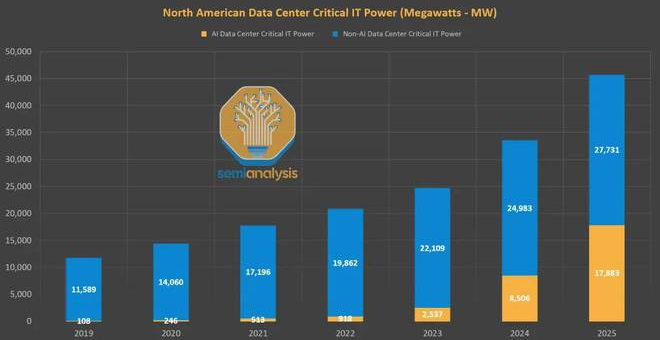

- 電力限制

2030年,數據中心的電力需求可能會達到1至5 GW,以支持2e28至3e29 FLOP的訓練運行(GPT-4的訓練規模估計約為2e25 FLOP)。地區性的分布式訓練可以利用多個地區的電力基礎設施來擴大規模。根據美國數據中心的擴展預測,美國的分布式網絡可能支持2至45 GW的電力供應,從而實現2e28至2e30 FLOP的訓練運行。這需要多年的規劃和對新發電廠的投資。 - 芯片製造能力

人工智能芯片提供了訓練大型AI模型所需的計算能力。然而,擴展芯片生產受到先進封裝技術和高帶寬內存的限制。即便如此,隨著製造商擴大規模並提高硬件效率,1億個H100等效的GPU可能專門用於訓練,這能夠支持高達9e29 FLOP的運行。不過,這一預測存在很大的不確定性,因為H100 GPU的供應範圍可能從2000萬到4億個不等,相當於1e29到5e30 FLOP。 - 數據稀缺

訓練大型AI模型需要海量數據。目前網絡上大約有500T的獨特文本數據,預計到2030年將增加50%。多模態學習將有助於擴展數據量,數據規模可能增長三倍。考慮到數據質量、可用性等因素,2030年可用於訓練的token數量估計在4億萬億到20億億之間,這將支持6e28到2e32 FLOP的訓練規模。 - 延遲牆

延遲牆是一種由計算過程中不可避免的延遲所引起的速度限制。隨著模型規模的擴大,訓練需要更多順序操作。報告估計,當前的GPU設置下,累積延遲會將訓練運行的FLOP上限設定在3e30到1e32。超越這一上限需要新的網絡拓撲結構以減少通信延遲。

未來的發展與挑戰

報告指出,儘管存在這些限制因素,但若能有效應對,到2030年實現2e29 FLOP的訓練運行是可行的,這將代表目前AI模型的10000倍擴展。這一擴展將標誌著AI技術歷史趨勢的持續,並有可能帶來前所未有的突破性進展。